In einer neuen Studie, die im Science Magazine veröffentlicht wurde, versucht das Data Science Team von Facebook zu widerlegen, dass der News Feed des Social Networks uns nur mit Informationen versorgt, die zu unserer eigenen Meinung passen. Doch es gibt Kritik an den Ergebnissen.

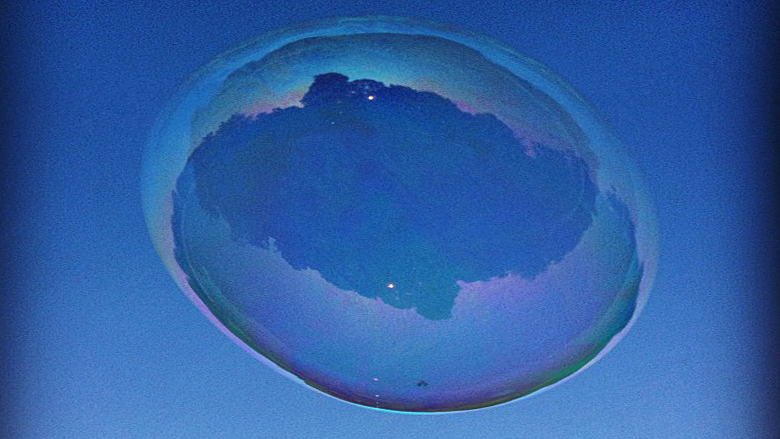

Facebook könnte man mit 938 Millionen täglich aktiven Nutzern durchaus als die größte Tageszeitung der Welt bezeichnen – in den USA sagen etwa 30 Prozent der Erwachsenen, dass die wichtigste Quelle für News Facebook ist. Kein Wunder: Seit geraumer Zeit mischen sich viele Links zu News-Artikel unter den restlichen Content, und für Online-Medien hat sich das Social Network zu einer wichtigen Traffic-Quelle entwickelt. Kritik an der Auswahl der Meldungen, die den Usern präsentiert werden, gibt es schon länger. Eli Pariser, heute Chef der Viral-Content-Seite Upworthy, hat 2012 mit seinem Buch “The Filter Bubble” den Begriff der Filterblase geprägt und eindrücklich davor gewarnt, dass uns Facebook nur Inhalte präsentiert, die zu unseren Meinungen und Einstellungen passen und ausblendet, was ihnen widerspricht.

Eine kleine Stichprobe

Das Data Science Team von Facebook um Eytan Bakshy versucht nun, diese Vorwürfe zu wiederlegen. Einer eigenen Studie zufolge, bei der das Klickverhalten von 10,1 Millionen Facebook-Nutzern analysiert wurde, sollen die User ein deutlich breiteres Spektrum an politischen Nachrichten zu sehen bekommen, als Kritiker sagen. Den Ergebnissen zufolge würde der Algorithmus, der die Inhalte im News Feed bestimmt, vor konservativen Nutzern nur fünf Prozent der liberalen Inhalte verstecken, liberal gesinnte User würden acht Prozent der konservativen Inhalte nicht zu sehen bekommen. Außerdem sei die Wahrscheinlichkeit, dass ein konservativer Nutzer auf einen liberalen Inhalt klickt, nur um 17 Prozent geringer als bei anderen Inhalten, Liberale kämen dabei auf nur sechs Prozent. Insgesamt, so die Studie weiter, hätten im Schnitt 23 Prozent der Facebook-Freunde eine konträre politische Einstellung, 29 Prozent der News-Stories würden eine Sichtweise repräsentieren, die mit der Meinung der User in Konflikt steht. Insgesamt sollen nur sieben Prozent der User auf “harte News”, also Inhalte zu nationalen oder internationalen Politik, klicken.

Die Schlussfolgerung der Facebook-Forscher: Nicht der Algorithmus, der die Beiträge für den Nutzer auf Basis seiner Daten (Freunde, Likes, Klickverhalten, etc.) auswählt, sei schuld an der Filterblase, sondern die Nutzer selbst. Entscheidend sei die Größe und die Diversität des Freundeskreises, von dem die Nachrichten kommen. Das ist sicher plausibel: Menschen haben sich in Höhlen, Zünften, Vereinen, Parteien, Kämmern und anderen Gemeinschaftsformen schon immer gerne mit jenen umgeben, die die eigene Lebensweise teilen. Die Hoffnung, dass die Digitalisierung diesen Scheuklappen-Effekt aufbricht und für eine breite Wahrnehmung an Meinungen und Positionen sorgt, dürfte sich so schnell nicht erfüllen.

Einseitige Nachrichtenauswahl

Kritik an der Facebook-Studie kommt etwa von der Journalistin Eva Wolfangel, die dahinter eine PR-Aktion zur Image-Aufbesserung von Facebook vermutet. “Bakshy und seine Kollegen bestätigen, dass der Algorithmus zu einer einseitigen Nachrichtenauswahl führt“, schreibt Wolfangel in Bezug auf das Forscher-Team von Facebook. “Welche Neuigkeiten ein Nutzer ganz oben angezeigt bekommt, entscheidet sich unter anderem danach, wie oft dieser Facebook besucht, wie intensiv er mit bestimmten Freunden interagiert und welche Links seines Newsfeed er in der Vergangenheit angeklickt hat. Neu ist lediglich die Erkenntnis, dass die Nutzer offenbar mehr Vielfalt präsentiert bekommen, als sie aufnehmen.“

Auch die Forscherin Zeynep Tufekci von der University of North Carolina kann der Studie wenig abgewinnen. Aufgrund der Auswahl der Stichprobe (es wurden nur US-Nutzer ausgewählt, die ihre politische Einstellung selbst angegeben haben) könne man nicht auf die Gesamtheit schließen. Was sie aus der Studie liest: Der wahre Gatekeeper sei die Platzierung im News Feed, weil ganz oben positionierte Links viel mehr Klicks bekommen als jene, die unten gereiht werden. Forscher Christian Sandvig von der University of Michigan weist darauf hin, dass der News Feed bei Konservativen einen von 20, bei Liberalen einen von 13 konträren Artikeln filtere. Nathan Jurgenson, der für den Facebook-Rivalen Snapchat forscht, hat sich ebenfalls über die Studie ausgelassen und meint, dass die Studie methodisch schlecht durchgeführt worden sei und nicht von Science so schnell veröffentlicht hätte werden dürfen.

Was lernt nun unsereins von der wissenschaftlichen Debatte rund um den News Feed? Wer auch immer nun Schuld an der Filterblase ist – ob Algorithmus, Freundeskreis oder wir selbst –, man sollte sich der Echokammer immer bewusst sein und aktiv versuchen, konträre Meinungen wahrzunehmen. Sonst schwimmen wir noch in 100 Jahren in der eigenen Suppe.